【新智元导读】LLM练习速率还不错再飙升20倍!英伟达团队祭出全新架构归一化Transformer(nGPT),陡立文越长,练习速率越快,还能保管原有精度。

AI的改日,或者就此改写......

最近,英伟达团队抛出的一枚重磅炸弹,提议了全新神经积蓄架构——归一化Transformer(nGPT),基于超球面(hypersphere)进行线路学习。

相较于Transformer架构自身,nGPT平直将LLM练习速率升迁至高20倍,而且还保合手了原有精度。

也就意味着,本来需要一个月完成的练习,在改日可能只需1-2天的时刻就能治理。

无疑为通向AGI终极主义,注入了一针强心剂!

论文地址:https://arxiv.org/pdf/2410.01131

在nGPT中,所有的向量(镶嵌、MLP、介意力矩阵、掩饰现象),王人被归一化为单元范数(unit norm)。

输入后的token在超球面名义上挪动,每一层王人通过「位移」来孝敬最终的输出揣度,其中位移量是由MLP和介意力模块进行界说的,其向量组件王人位于团结个超球面上。

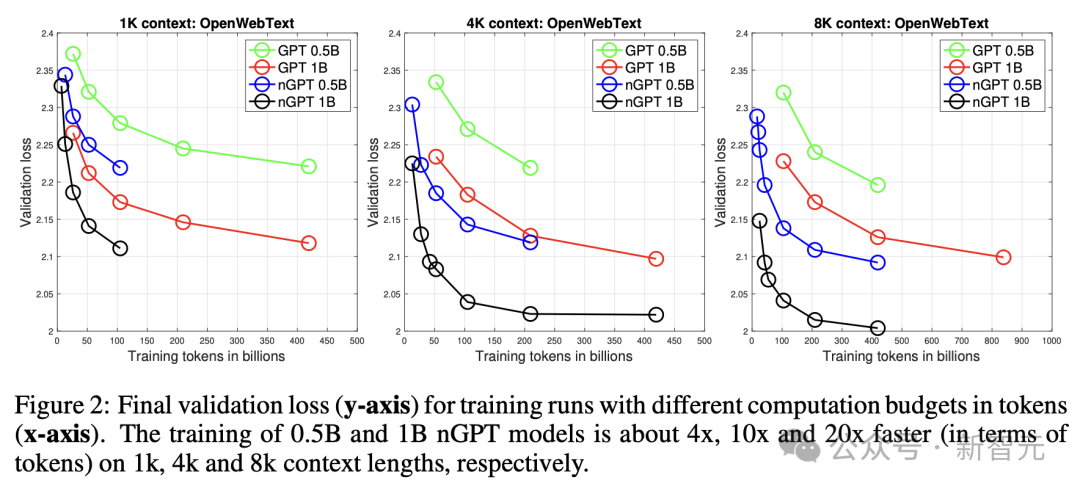

实验标明,nGPT达到相通精度所需的练习方法减少了4-20倍,具体取决于序列长度:

- 1k陡立文,练习速率提高4倍

- 4k陡立文,练习速率提高10倍

- 8k陡立文,练习速率提高20倍

不错看出,陡立文越长,练习越快。

Reddit网友线路,「我很意思它还能彭胀到多猛进度。要是它能在更长的陡立文中大幅彭胀,这意味着像o1这么的模子将会赢得权贵的练习速率上风」。

还有东说念主线路,「下一代模子将会更高效、更智能」。

nGPT全新架构,超球面上归一化

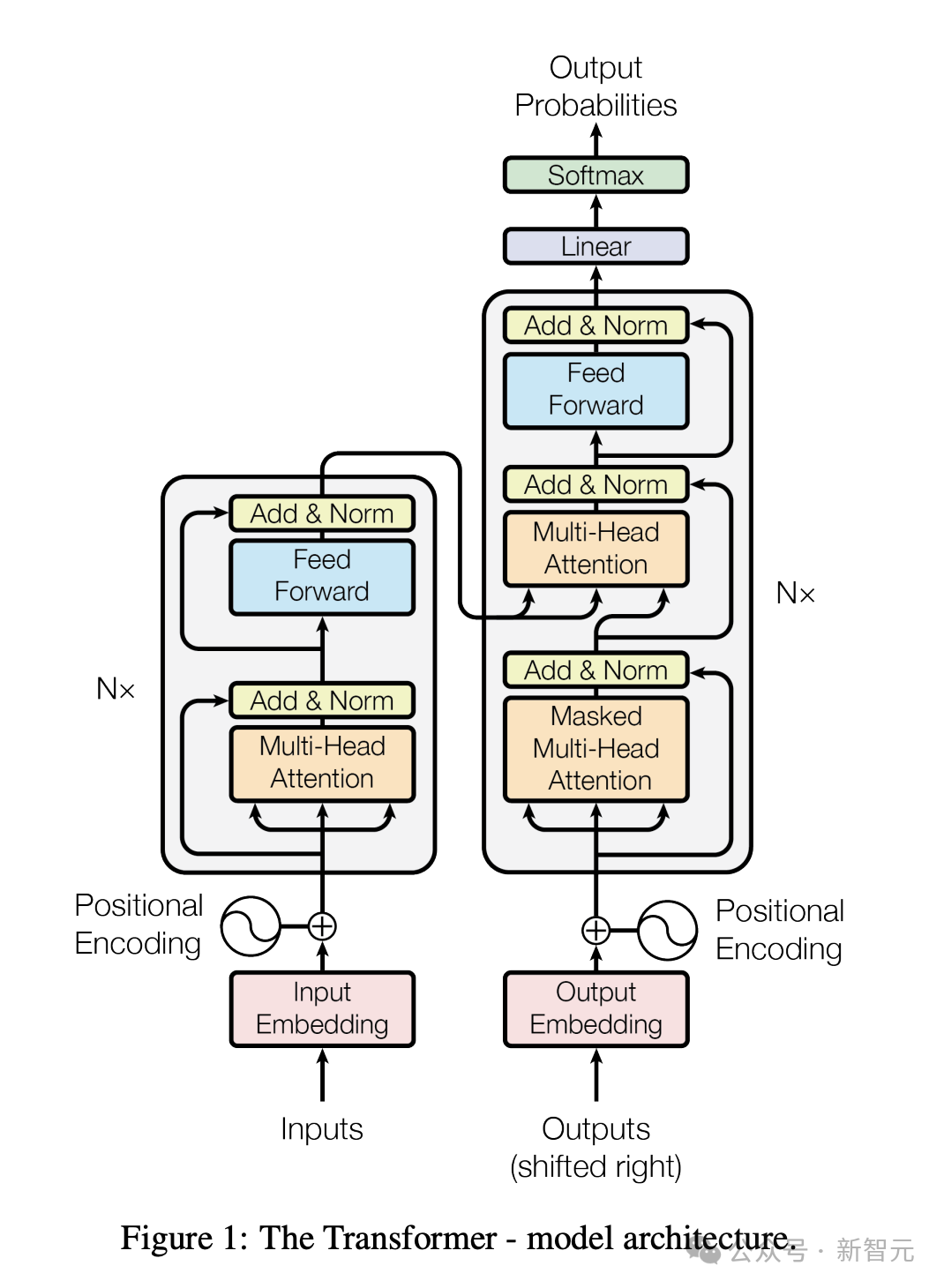

无谓置疑,Transformer架构是当代大模子的基础。

不外,面前基于Transformer搭建的大模子王人是盘算密集型的,需要消耗多半的资源和时刻。

为了修订其练习褂讪性、推理老本、陡立文长度、鲁棒性等方面,AI科学家已进行了多半的修改尝试。

其中,最超越的发现是,归一化本领关于Transformer性能改善起着紧迫作用,比如LayerNorm和RMSNorm。

另一种模子归一化方法是,通过权重衰减(weight decay)禁止权重范数。

不外,最新磋商又对权重衰减的作用进行评估,何况转向更多地更始旋转,而非只是更始向量范数。

越来越多的笔据标明,在超球面上进行线路学习与更褂讪的练习、更大的镶嵌空间可分离性以及不才游任务上的更好性能磋商。

而且,还有新磋商标明,Transformer隐式地履行梯度下落看成元优化器。

由此,英伟达团队提议了,在归一化Transformer新视角下,长入该领域的多样发现和不雅察。

这项磋商的主要孝敬在于:

- 在超球面上优化积蓄参数

建议将形成积蓄矩阵镶嵌维度的所有向量归一化,使其位于单元范数超球面上。这种方法将矩阵-向量乘法更始为余弦相似度的盘算,其范围截至在 [-1,1] 之间。而回去一化排斥了对权重衰减的需求。

- 归一化Transformer看成超球面上的可变度量优化器

归一化Transformer自身在超球面上履行多步优化(每层两步),其中介意力和MLP更新的每一步,王人由特征学习率禁止——这些是可学习的可变度量矩阵的对角线元素。

关于输入序列中的每个token

,归一化Transformer的优化旅途从超球面上对应于其输入镶嵌向量的点驱动,挪动到超球面上最能揣度下一个

的镶嵌向量的点。

- 更快的敛迹

磋商说明,归一化Transformer将达到相通精度所需的练习方法减少了4-20倍。

Transformer演变:从GPT到nGPT

镶嵌层归一化

门径的decoder-only Transformer的练习主义是根据输入序列的前序tokens来揣度背面的token丝袜脚,在token揣度时,模子会引入两个可学习的镶嵌矩阵Einput和Eoutput,辨认用来从输入词转为词镶嵌,以及从词镶嵌转为揣度输出。

在模子练习时代,通常使用对应镶嵌向量的点积来盘算token相似度,但镶嵌向量的范数(norms)不受限制的,可能会导致相似性盘算存在偏差。

为了提高相似性预料的准确性,磋商东说念主员在新架构中提议,在练习算法的每一步之后,对Einput和Eoutput中的镶嵌向量进行归一化。

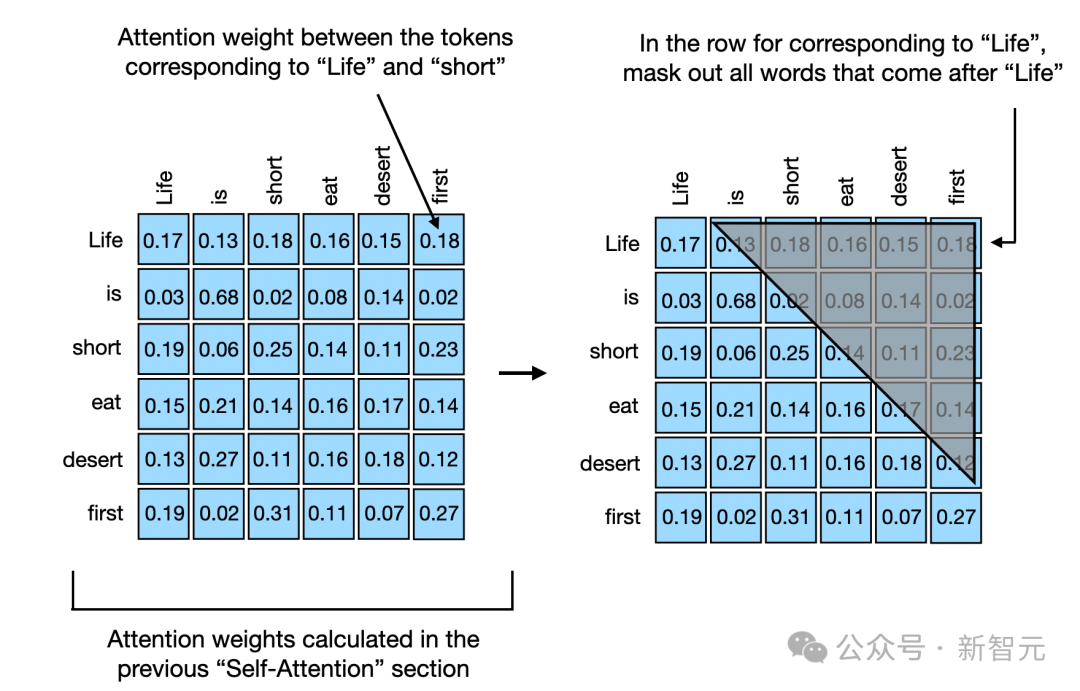

智能体在揣度文本中的下一个词时,会使用因果掩码(casual masking)来确保模子在揣度token时不会「偷看」到之后的词,酿成信息泄露,从而让模子能够同期揣度多个词并盘算揣度舛错,提高练习后果,同期保合手了按限定揣度词的才气。

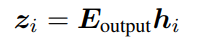

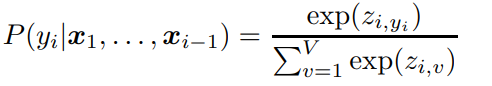

在输入词序列后,模子会在揣度序列中的每个位置王人生成一个输出向量,然后盘算出一个logits向量zi来线路词汇表中每个词出现的可能性,不错援手模子瓦解不同词在面前陡立文中的紧迫性:

之后用softmax函数把zi转为概率值,并及第概率最高的词看成下一个词的揣度。

少妇

由于nGPT的镶嵌矩阵依然归一化了,是以zi的值范围为[−1,1],也会限制softmax后得到的概率漫衍的置信度,也不错叫作念温度。

为了在练习经过中诊疗置信度,nGPT又引入了一个可学习的缩放参数sz,通过逐元素地缩放logits,模子不错更活泼地揣度的置信度,更好地学习到在不怜悯况下若何作念出更准确的揣度:

层/块归一

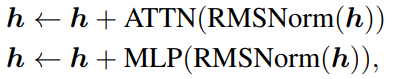

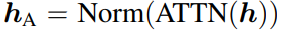

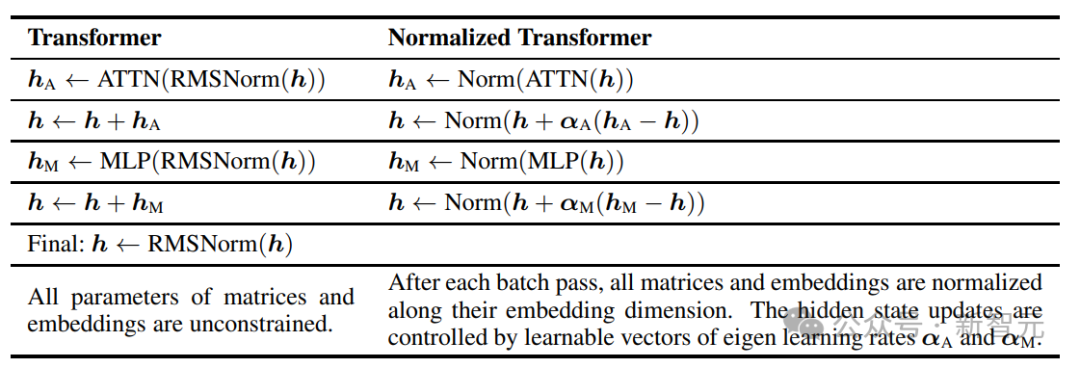

门径Transformer架构需要对掩饰层现象h进行L层变换,包括一个自介意力(ATTN)和多层感知机(MLP)。

其中RMSNorm也不错替换成其他归一化(normalization)函数。

掩饰层的参数更新,其实即是在一个超平面上(维度为掩饰层的向量长度)寻找两个点(原参数和新参数)的最短距离。

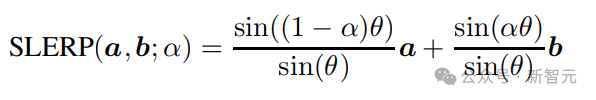

1985年,Shoemake提议了球面线性插值(SLERP,Spherical Linear Interpolation),不错沿着球面上两点之间的最短旅途找到中间点,磋商东说念主员发现该方法还不错通过更纯粹的线性插值(LERP,linear interpolation)来得到近似解,从而裁汰盘算量:

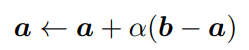

按最短旅途寻找来说,参数更新经过不错面目为:

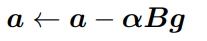

其中a和b是球面上的两个点,对应到nGPT上,a也即是掩饰层现象,b是经过介意力机制或MLP块后的现象,梯度即是g=a-b,B为可变矩阵。

在拟牛顿方法中,B不错近似于逆黑塞矩阵,当 B是一个对角线元素非负的对角矩阵时,αB就变成了一个向量,其元素对应于B的对角线元素乘以学习率α,也不错称之为特征学习率(eigen learning rates)。

eigen源自德语词,意为「我方的」(own),不错指代Transformer 的里面结构。

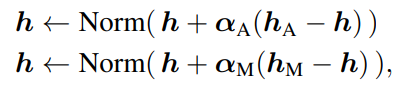

是以nGPT中的参数更新方程不错写为:

其中αA 和 αM是可学习的参数,辨认用于介意力和多层感知机(MLP)模块的归一化输出 hA和 hM

与基础 Transformer 比较,在nGPT的最终层之后不需要再进行很是的归一化了。

自介意力块

介意力机制不错说是Transformer中最紧迫的模块,序列中的每个token王人能够更始到其他所有token,从而让模子具有捕捉长距离依赖相干的才气。

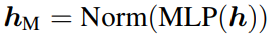

模子会把处理后的信息分解成三个部分:查询(q,query)、键(k,key)和值(v,value),不错援手详情哪些信息是紧迫的,以及信息之间是若何互磋商联的。

为了确保模子能够瓦解每个词在序列中的位置,模子中通常还会在query和key向量之间加入旋转位置镶嵌(Rotary Position Embeddings,RoPE)。

然后通过盘算query向量和key向量的点积、缩放、应用softmax得到介意力权重,对value向量进行加权乞降,得到介意力得分。

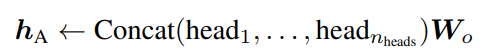

在执行中,Transformer一般王人会用到多个介意力头,其中每个头的介意力机制王人是孤独盘算,临了再通过一个可学习的投影矩阵Wo合并所有头输出。

在盘算介意力得分的经过中,权重矩阵莫得受到太多限制,可能会导致最终得分过大或过小。

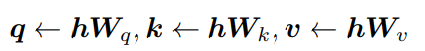

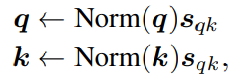

在nGPT中,磋商东说念主员对q向量和k向量进行归一化,还引入了一些可诊疗的参数(sqk),以确保权重矩阵在处理位置信息时不会失真,更准确地捕捉到句子中词与词之间的相干,从而作念出更好的揣度和有规划。

MLP块

在门径Transformer中,掩饰层收入通过RMSNorm进行归一化,然后经过两个线性投影生成中间向量(暂不接头偏置项):

然后使用SwiGLU 门控激活函数,以及一个线性变换得到最终门控激活。

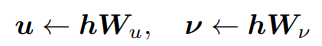

在nGPT中,磋商东说念主员提议对线性投影的权重矩阵进行归一化,并引入可学习的缩放因子,能够更充分地诈欺处理信息时的非线性特点,在处理复杂信息时愈加活泼。

多层感知机模块的输出不会因为缩放诊疗而发生变化。

Adam高效学习率

Adam优化算法通过动量和梯度幅度的预料来诊疗每次的学习步长,同期接头了面前及畴前的梯度信息。

在nGPT中,磋商东说念主员不异引入了一个可练习的缩放参数向量,对特定的参数进行更综合的禁止,确保每个参数王人能以最合适我方的速率进行学习,从而进一步提高学习后果。

在不影响全局学习率的情况下,对特定的参数进行诊疗,提供了更大的活泼性和禁止力。

变化转头

和基础Transformer比较,nGPT主要作念了七个改革:

1、移除所有归一化层,比如RMSNorm或LayerNorm;

2、在每个练习方法之后,沿着镶嵌维度对所有矩阵,包括输入输出镶嵌矩阵,以及多样权重矩阵进行归一化处理;

3、修改了掩饰层参数更新方程;

4、诊疗介意力机制中的softmax缩放因子,对q和k进行从头缩放和归一化;

5、对MLP块的中间现象进行从头缩放;

6、对logits进行从头缩放;

7、移除权重衰减和学习率预热方法。

陡立文越长,练习速率越快

接下来,磋商东说念主员在OpenWebText数据集上练习了基础基础Transformer(GPT)和归一化Transformer(nGPT),并在一系列门径卑鄙任务上对其进行评估。

实验中,使用了0.5B和1B(包括镶嵌)两种参数规模的模子。两种参数规模的模子0.5B和1B(包含镶嵌)。

练习加快

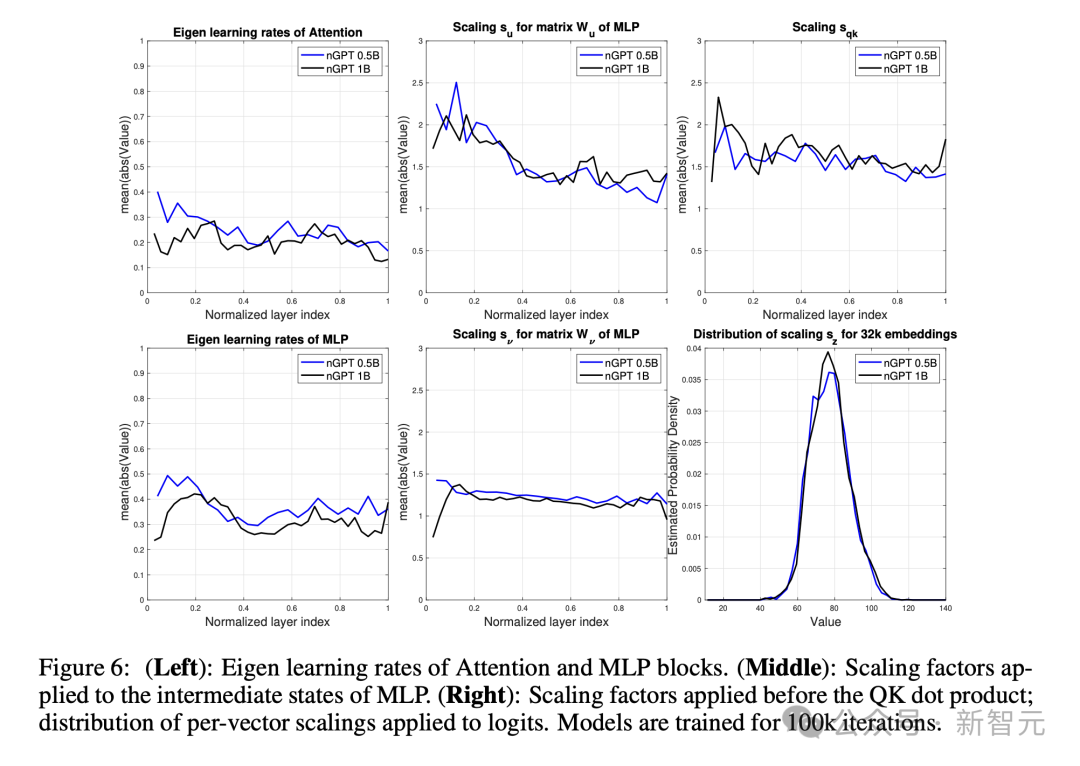

图1流露了,在练习经过中,10亿参数且样本长度为4k token的GPT和nGPT模子的考证亏蚀。

经过2万次迭代后,nGPT达到了与GPT在20万次迭代(约4000亿个token)后,才气达到的相通考证亏蚀。

这标明,在迭代次数和使用token数目方面,nGPT竣事了10倍的加快。

再来看图2,展示了nGPT和GPT在三个方面的性能差距是若何变化的:总token数目、陡立文长度、参数规模。

在1k、4k和8k token陡立文中,练习0.5B和1B的nGPT模子辨认约快4倍、10倍和20倍。

图3不才游任务中流露了访佛的性能,说明加快不仅反馈在困惑度上,也反馈在职务发挥上。

磋商东说念主员不雅察到,关于较长的练习运行,nGPT流表示一些足够自恃,这示意在面前可练习参数数目下,模子容量可能已接近极限。

神经积蓄参数查验

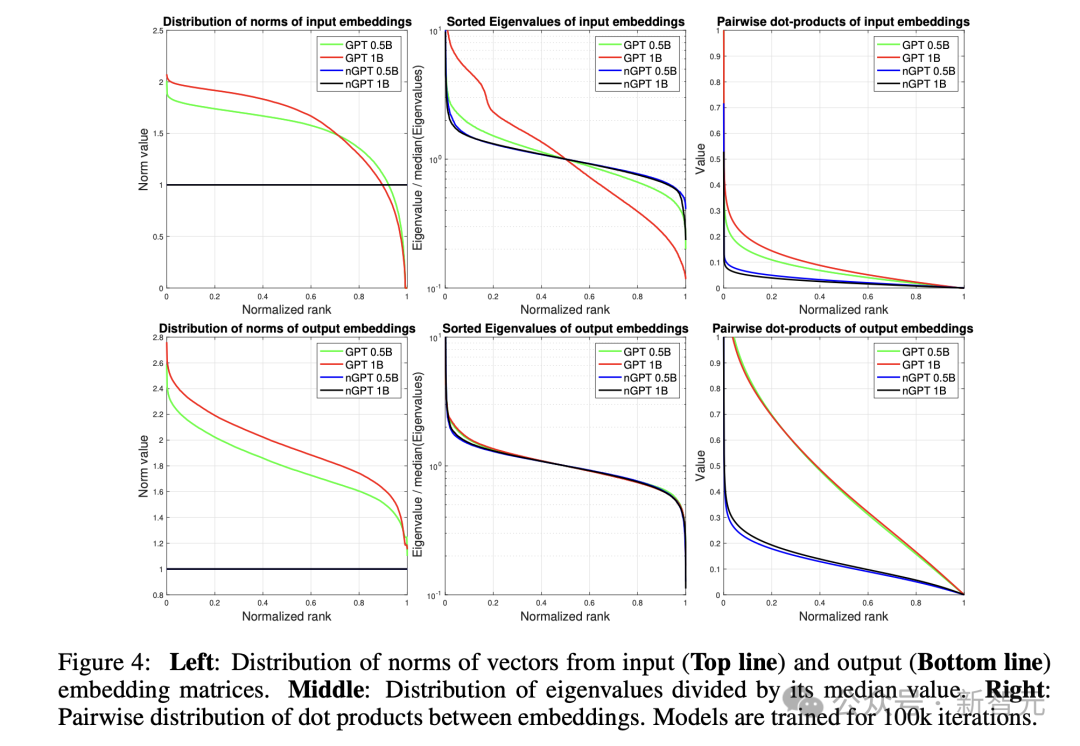

图4流露,诚然nGPT保合手固定的镶嵌范数(这是想象使然),但GPT发挥出彰着的变化。

从镶嵌的协方差矩阵盘算得出的特征值漫衍(依然由其中位数归一化)流露,GPT的输入镶嵌具有更高的要求数,尤其是在1B模子中。

镶嵌之间的成对点积漫衍标明,即使在nGPT中,镶嵌也并非均匀漫衍在超球面上(在何处点积会接近0),而是形成簇——这可能反馈了话语数据中的当然时势。

由于GPT的镶嵌形成了一个超椭球体(hyper-ellipsoid),如向量范数的漫衍所示,其点积通常具有更高的值。

GPT输入镶嵌的病态性质(ill-conditioned nature)可能导致波及这些镶嵌的盘算问题。

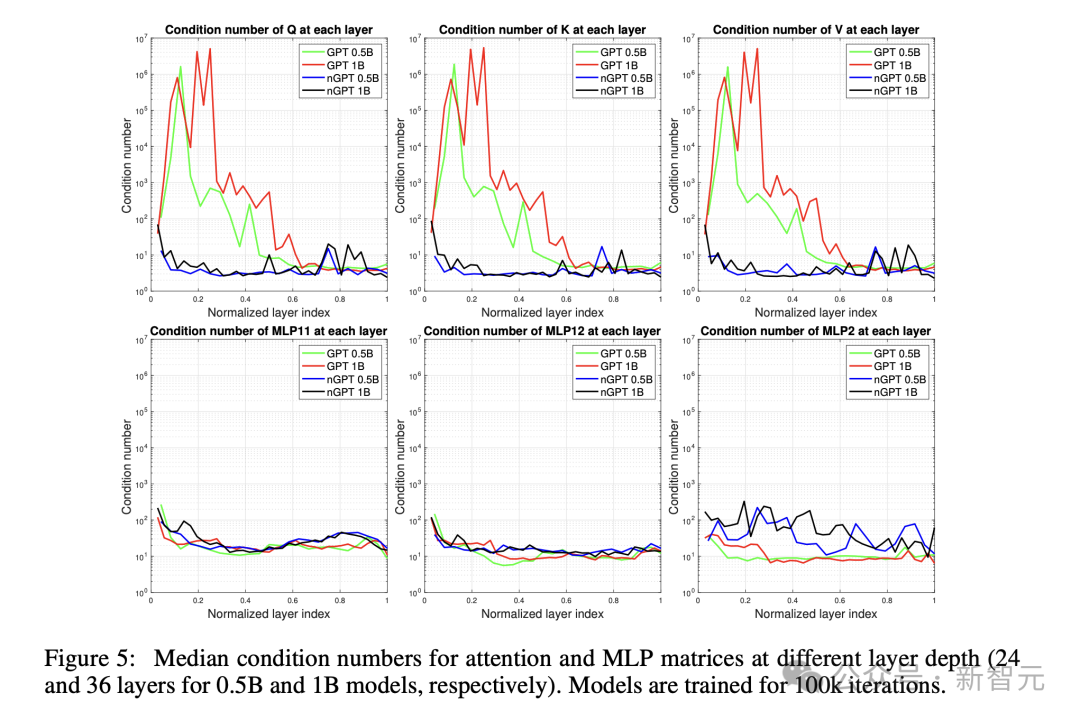

下图5展示了,介意力和MLP矩阵在不同层深度上的中位数要求数(跨多个头)——0.5B模子有24层,1B模子有36层。

与nGPT比较,GPT模子的介意力矩阵呈现权贵更高的要求数。

对这些矩阵的进一步查验,GPT的介意力矩阵发挥出退化为低秩矩阵的趋势,可能减少了这些块的学习容量。

下图6展示了,(左图)介意力模块和MLP模块的特征学习率,(中图)应用于MLP中间现象的缩放因子,(右图)应用于QK点积之前的缩放因子。